迈特芯科技最新发布支持DeepSeek蒸馏版及满血版的异构FPGA一体机整机设计方案。借助新的硬件架构支持混合专家模型(MoE)架构、多头潜在注意力机制(MLA)等算法创新,率先将智能芯片、服务器硬件、算法框架、行业应用软件等深度集成,形成本地化“开箱即用”的智能算力解决方案。该产品方案降低了对高算力GPU的依赖,显著降低了硬件成本,并适用于多种行业场景,可广泛应用于金融、医院、物流、政务等领域。

迈特芯推出的异构FPGA DeepSeek一体机覆盖7B到671B规模的DeepSeek大模型,提供私有化部署、行业场景定制、高效安全合规的端到端解决方案。

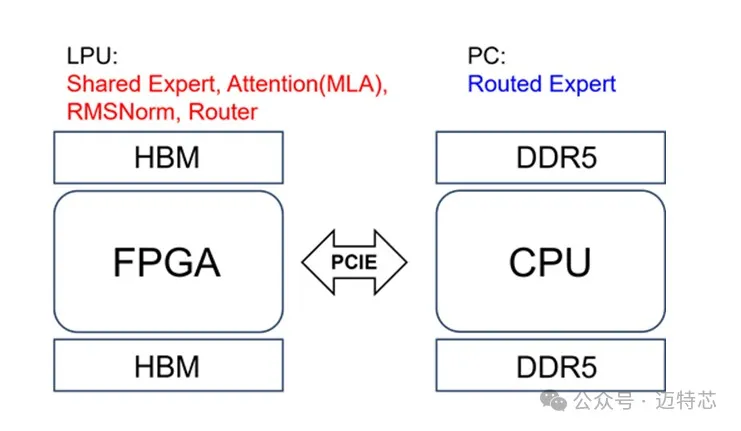

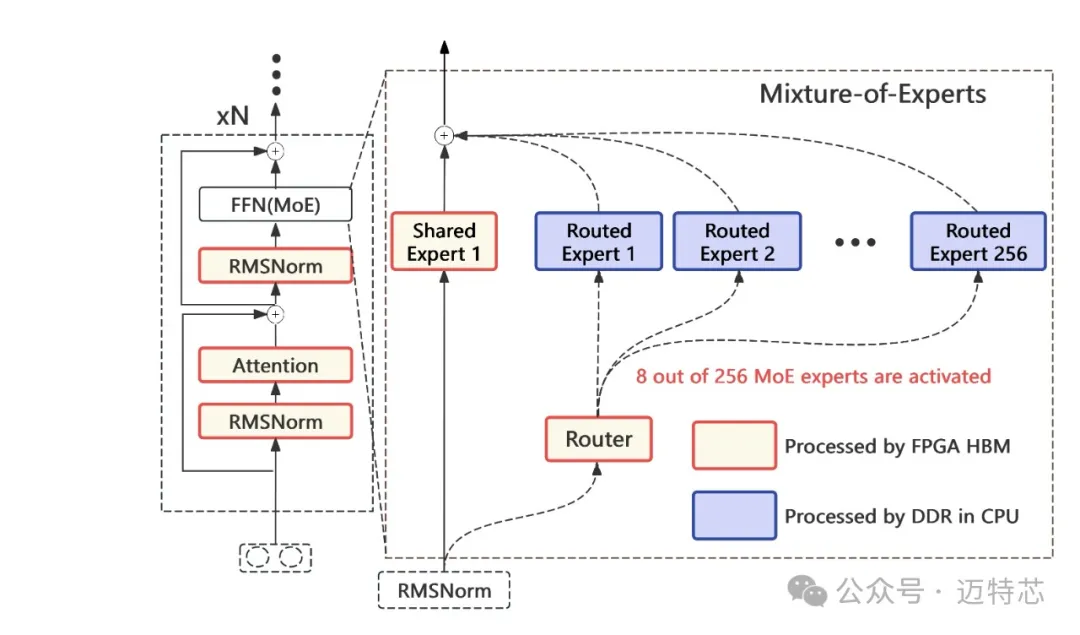

迈特芯LPU-DS硬件架构支持DeepSeek-R1网络的MLA及MoE推理,通过硬件实现 MLA和MoE算子,实现高推理速度,整体功耗小。MLA通过对注意力机制中Key和Value进行地址压缩从而显著减少网络推理所需的KV cache。MoE通过组合多个“专家”模型来处理复杂任务的架构。每个“专家”模型专门处理输入数据的某一部分,而一个门控网络(Softmax)则负责决定哪些专家应该被激活。迈特芯方案为实现大模型网络推理设计了不同的算子(低秩张量压缩算子等),所有算子都采取一种全局统一数据类型,实现所有算子的串联,提高硬件的执行效率和总线的利用率。

迈特芯FPGA异构方案支持常用轻量级大模型,如Qwen2-instruct-7B和DeekSeek的蒸馏版Qwen2-instruct-7B,处理性能最高可达75 Tokens/s,大约是A100性能的两倍。

迈特芯DeepSeek FPGA异构一体机凭借其卓越的性能、强大的硬件支持、广泛的应用场景、严格的数据安全措施以及良好的用户体验,成为了企业级用户在高精度、高性能需求场景下的理想选择。客户可以根据需求应用场景、预算选择不同档次的配置,产品可用在私有环境搭建轻量便捷、低成本的满血版DeepSeek推理平台。产品覆盖DeepSeek 7B至671B大模型,支持DeepSeek的高效推理,推理速度最高可以达到50 token/秒。

文章来源:迈特芯科技