作者:张海军,来源:傅里叶的猫

下午有个朋友问我,现在AI发展这么快,怎么没听过FPGA有什么动静,难道FPGA就真的搭不上AI这趟列车了吗?

从目前工业界的情况来看,确实FPGA在AI方向的应用并不是很理想,目前业界主流的两个AI框架PyTorch和TensorFlow都是基于GPU的,FPGA相对来说,就没有那么灵活,没法快速适配新的算法。

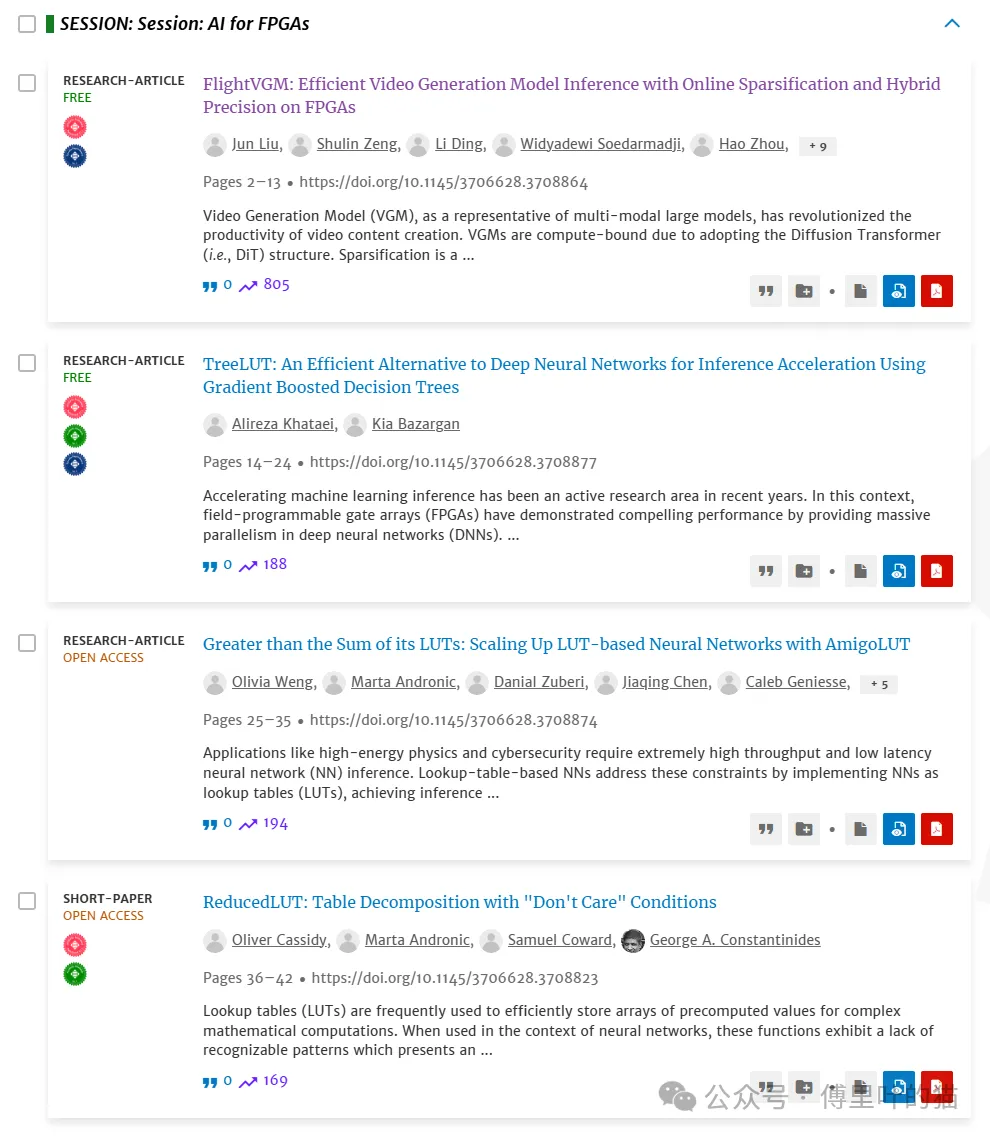

当然学术界也一直为此做努力,这篇文章我们就来看下,最新的2025 FPGA学术会议上,跟AI相关的4篇论文,了解一下FPGA在AI上的最新成果。

看到这4篇论文,首先的感受就是中国在AI或者科技上的人才真的是多,2025 FPGA会议上的4篇AI论文,有一篇是上海交大和清华大学共同发表的一篇论文,还有一篇的作者列表中,也有两个中国人的名字。所以大家都调侃,AI的竞争,其实就是中国人和在美国的中国人的竞争。

四篇论文都讲了什么内容?

1. FlightVGM: 基于FPGA的高效视频生成模型推理加速

论文的核心内容:视频生成模型(VGM)采用扩散变换器(DiT)结构,计算密集且GPU难以高效处理稀疏计算。

时空在线稀疏化:利用视频帧间(时间)和帧内(空间)相似性动态剪枝激活,减少3.17倍计算量。

混合精度DSP扩展架构:在AMD V80 FPGA上结合FP16和INT8精度,提升3.26倍峰值计算性能。

动态-静态调度:通过权重预加载和优先级调度优化稀疏计算利用率,提升2.75倍。

成果:相比NVIDIA 3090 GPU,性能提升1.30倍,能效提升4.49倍,适用于Latte-1、Open-Sora等模型。

2. AmigoLUT: 基于集成学习的LUT神经网络扩展

论文的核心内容:传统LUT神经网络(如LogicNets)随输入维度指数级消耗FPGA资源,难以扩展。

集成学习框架:通过平均集成多个小规模LUT模型(如PolyLUT、NeuraLUT),线性扩展性能。

多样性优化:提出多样性可视化分析工具,平衡模型间差异与误差,提升集成效果。

成果:在MNIST、高能物理数据集(HGCal/JSC)上,资源消耗降低一个量级,吞吐量显著提升。

3. ReducedLUT: 利用无关项优化的LUT压缩方法

论文的核心内容:LUT压缩中未充分利用训练数据未覆盖的输入组合(“无关项”)。

无关项识别与替换:将未观测输入的输出值替换为可优化值,增强子表间相似性。

动态回溯搜索:通过调整无关项值,最大化子表依赖关系,减少唯一子表数量。

成果:在MNIST、JSC等数据集上,LUT资源减少8.7%(几何均值),保持模型准确率不变。

4. TreeLUT: 基于梯度提升决策树(GBDT)的高效推理加速

论文的核心内容:DNN计算密集且硬件成本高,而GBDT结构天然适合FPGA实现。

量化方案:结合预训练和训练后量化,将决策树阈值和叶值映射到低比特整数。

全展开流水线架构:将GBDT分解为三层组合逻辑(特征生成、决策树、加法树),避免BRAM/DSP。

成果:在MNIST、JSC等数据集上,硬件成本(面积-延迟积)比LUT神经网络低4-101倍,准确率97%。

这四篇论文有什么共同点

他们都是在提升计算效率(如TOPS、延迟)和能效比(性能/功耗),对比对象包括GPU(如NVIDIA 3090)或其他FPGA方案。

FPGA本质上还是一个工程性的平台,在AI方向最适合FPGA肯定还是优化,通过各种更高效的算法和架构,将AI任务解构为FPGA资源的最优配置问题,最终在特定场景(如视频生成、高能物理实时处理)中实现超GPU的能效和超通用处理器的灵活性,从而在AI计算生态中占据“高能效专用求解器”的差异化地位。

FPGA在AI领域的最新发展方向和成果总结

通过这4篇论文,我们可以看到FPGA在AI领域发展的核心脉络——通过硬件与算法的深度耦合,在特定场景中挖掘效率极限。

针对视频生成模型的时空冗余特性,设计动态稀疏化架构,将计算负载削减3倍以上,同时利用FPGA混合精度单元实现性能与能效的双重突破;面对神经网络因输入维度扩展导致的资源爆炸问题,通过集成学习将多个小型LUT模型组合成强分类器,既绕开单模型硬件限制,又保留FPGA的并行优势;甚至跳出神经网络框架,直接将决策树的逻辑判断固化为硬件电路,通过量化与流水线设计,在分类任务中以百倍级硬件成本优势碾压传统方案。

这些工作本质上都在探索同一条路径——让算法结构“生长”在FPGA的硬件土壤中,通过剪枝冗余计算(如激活稀疏化)、重构数据表达(如低比特量化)、硬件化模型逻辑(如决策树电路映射)等手段,将AI任务解构为FPGA资源的最优配置问题。

这种“硬件原生AI”的思路,不仅让FPGA在视频生成、高能物理等实时性要求严苛的场景中展现出超GPU的能效优势,更揭示了未来AI计算的一种可能性:当算法不再被通用硬件束缚,FPGA这类可编程平台或许会成为探索AI计算本质的新载体,特别是在边缘计算、生成式模型等前沿领域,为高能效、低延迟、强定制化的需求提供独特解法。

推荐两款FPGA加速卡

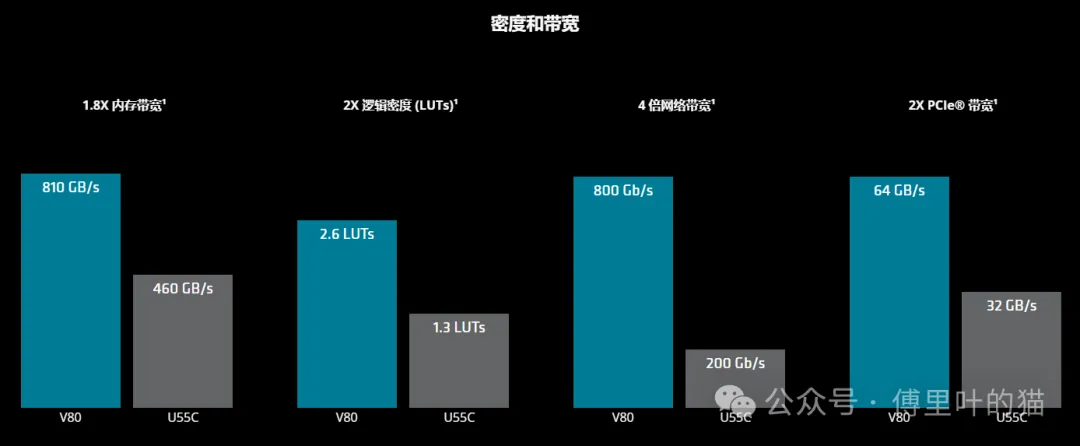

AMD Alveo V80加速卡和AMD Alveo U55C加速卡。

他们都是专门为高性能计算而专门设计的加速卡,最近来找我们咨询这两块板卡的人也非常多。

AMD Alveo V80 加速器支持自定义数据类型,支持 100 多个节点,适用于基因组测序、分子动力学和传感器处理等一系列高性能计算应用。

两款加速卡都内置加密引擎和灵活硬件助力定制包处理,非常适合防火墙和数据包监控等应用。该加速器卡的自定义数据移动功能也使其非常适合数据中心网络的 GPU 集群配置。

两款加速卡都具有低延迟处理能力和 HBM,可轻松应对大型数据集,实现出色能效、可扩展性并助力用户更快获得见解。