2019年4月,在春风飘荡的美丽青岛,人工智能行业大咖再次聚首:这里有权威声音、前瞻思维;这里汇聚了一线人工智能公司高管、新兴独角兽、新锐企业家、尖端科学家、跨界投资人;更有来自赛灵思、百度、华为、海信、海思、滴滴、科大讯飞等近百余家公司的企业家、科学家齐聚一堂,围绕人工智能新机遇、新挑战进行思想碰撞、尖峰论“智”。

AI的三大关键基础要素是数据、算法和算力。随着云计算的广泛应用,特别是深度学习成为当前AI研究和运用的主流方式,AI对于算力的要求不断快速提升,这也正成为制约人工智能落地的主要障碍。本次峰会上赛灵思人工智能市场总监刘竞秀为大家带来了“FPGA — 人工智能计算的加速引擎”的主题演讲,作为拥有中国/美国/欧盟/日本/韩国共45项专利申请的业界大咖,他给出了赛灵思的独家“秘笈”。

赛灵思人工智能市场总监刘竞秀AI Tech 2019 主题演讲“FPGA — 人工智能计算的加速引擎”

高性能计算平台的发展趋势

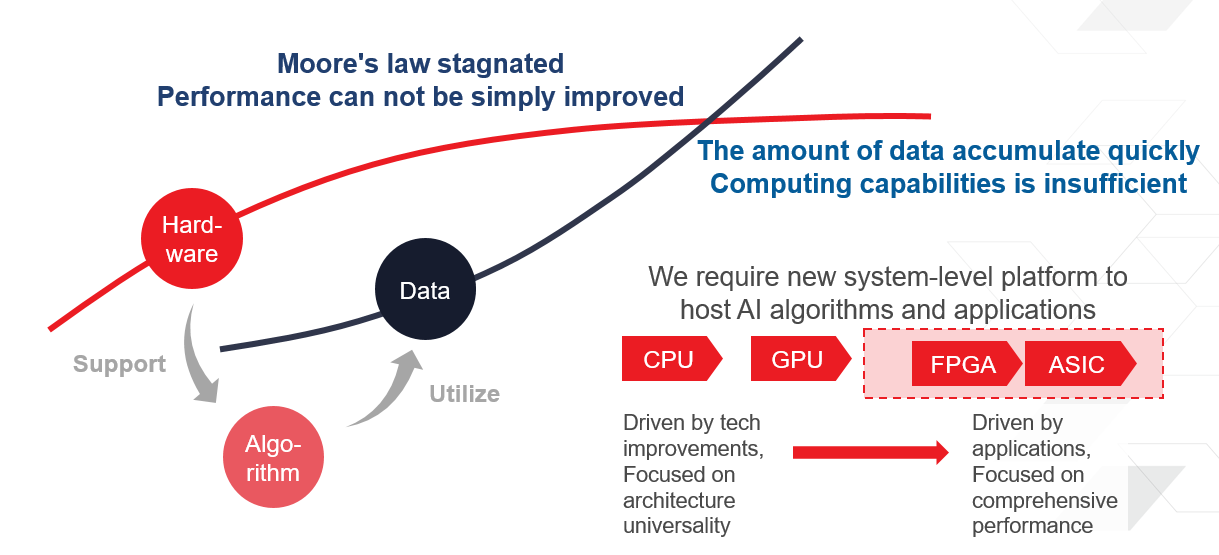

1, “剪刀差”一,呈指数增长的数据和计算芯片所能够提供的处理能力之间的“剪刀差”,受限于摩尔定律,传统芯片算力的进步已经远远跟不上爆炸性增长的数据对算力的需求。阿里巴巴总裁也曾提到他们目前使用的数据还不到掌握的数据的10%。

2,“剪刀差”二,传统芯片开发的长周期和快速迭代的市场和技术发展之间的“剪刀差”。芯片开发的完整的流程通常长达18~24个月,然而当前的AI项目经常需要几个月就提出解决方案,从而抢占市场,按照过去的芯片漫长的研发流片流程,当芯片出货时市场需求可能已经发生了根本的改变。

人工智能应用落地挑战:两大“剪刀差”

赛灵思独家“秘笈:灵活应变的AI通用平台

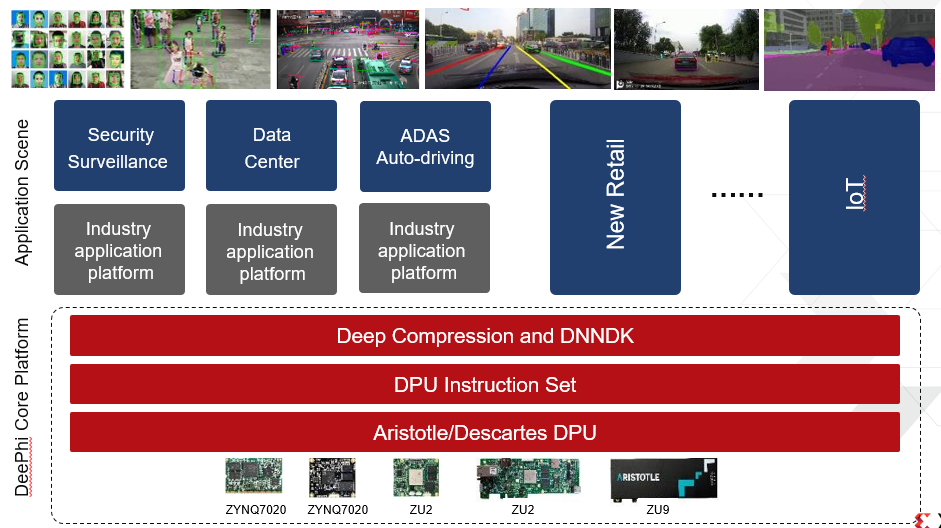

赛灵思为客户提供一站式解决方案,涵盖“顶层神经网络模型,中间层软件工具和IP,底层硬件”,打造人工智能时代的AI通用平台,帮助客户快速部署AI应用落地。

赛灵思边缘计算人工智能解决方案

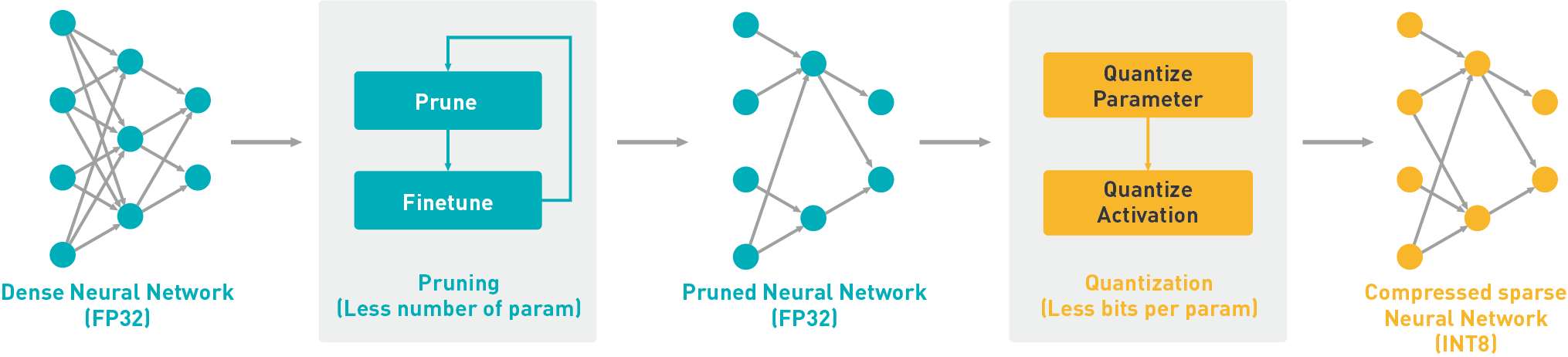

特色一、DECENT神经网络压缩工具

深度神经网络(DNN,Deep Neural Network)模型通常存在大量的信息冗余,从模型的参数数量到参数的表示精度都存在缩减的空间。依托世界领先的神经网络模型压缩领域研究成果,赛灵思研发了深度压缩工具DECENT(Deep Compression Tool),创新性的结合了剪枝(Prune)、量化(Quantization)等一系列压缩技术,在保证基本不损失算法精度的前提下可将网络模型的计算量和规模压缩数倍至数十倍,从而实现DPU平台深度学习应用更优的性能、更高的能效比、更低的系统内存带宽需求。

DECENT神经网络压缩工具

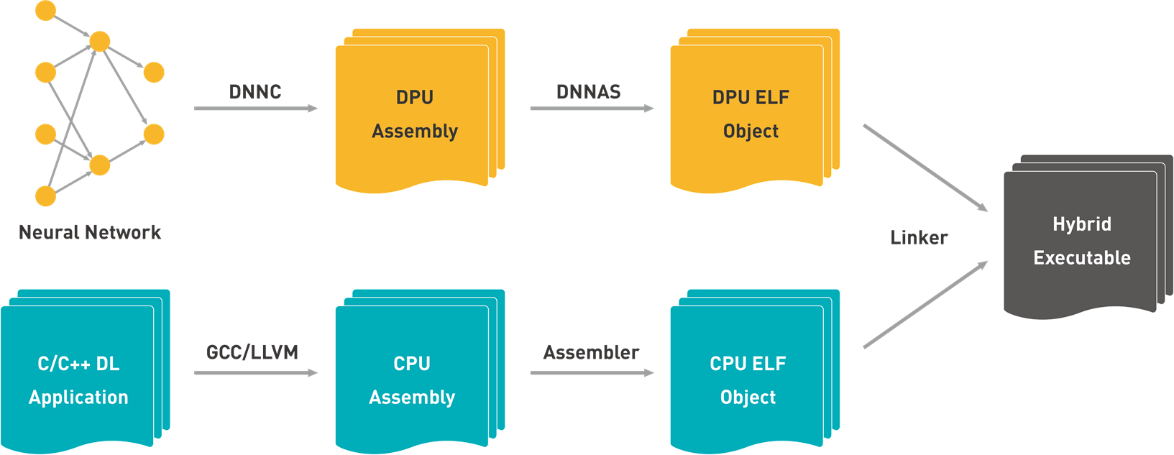

特色二、DNNDK混合编译模型

赛灵思混合编译技术创新性地解决了深度学习应用在 AI 异构计算环境下编译和部署中的困难,用户基于 C/C++ 高级语言开发、运行在 CPU 上的应用代码与运行在 DPU 上的神经网络指令流代码一起完成混合编译和链接,实现 DPU 平台深度学习应用的一键式便捷部署。

DNNDK混合编译模型

赛灵思核心商业布局

数据中心优先、加速核心主流市场的增长和驱动灵活应变的计算是赛灵思企业发展三大战略,新型ACAP(Adaptive Compute Acceleration Platform,自适应计算加速平台) 是赛灵思从半导体芯片企业向平台提供商转变的里程碑式产品类别

赛灵思八大核心主流应用

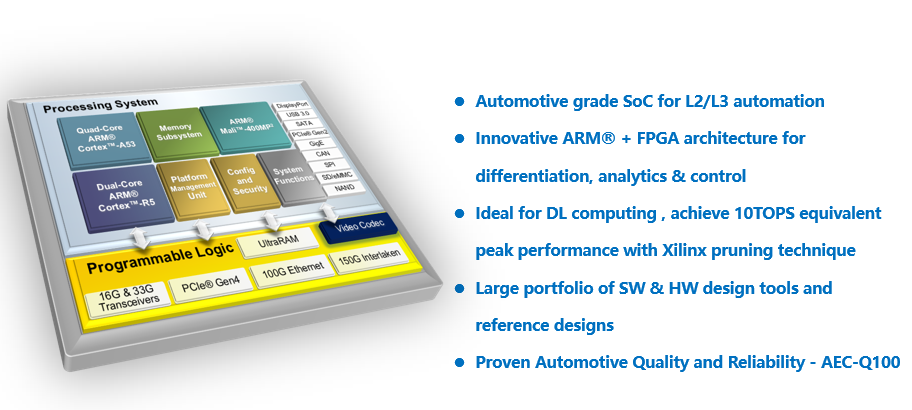

以汽车应用为例,携手东软睿驰在2019CES推出自动驾驶域控制器系统的合作,该控制器能够提供自动驾驶和自动泊车功能。这款新产品基于赛灵思汽车级的 Zynq MPSoC,配备了 SDK 和计算资源,支持汽车制造商开发自己的应用。

面向ADAS 的MPSoC 平台

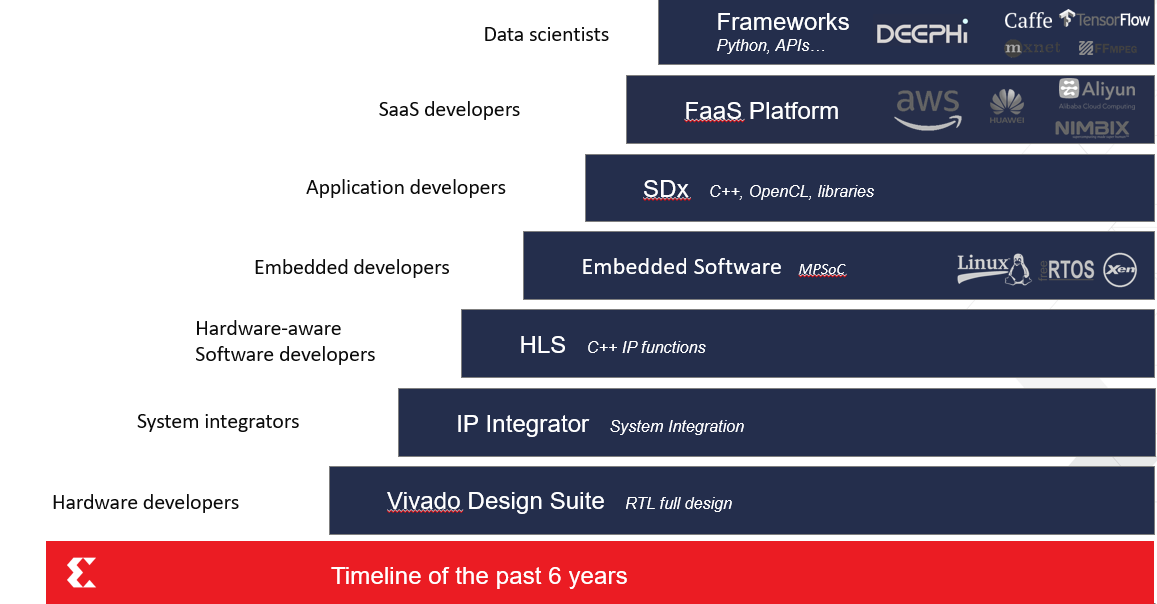

FPGA的最大优势在于可编程带来的配置灵活性,在目前技术与运用都在快速迭代的时期具有巨大的实用性,用户通过FPGA可以有效降低研发调试成本,提高市场响应能力,推出差异化产品。赛灵思打造面向所有开发者的生态环境、通用的处理器平台和完整的工具链,来加快人工智能产品落地的步伐。

赛灵思面向所有开发者的生态系统