来源:内容来自 semiengineering,谢谢。

大型语言模型加大了可持续计算和异构集成的压力;数据管理成为关键的区别因素。

领先的人工智能系统设计正在从构建尽可能最快的人工智能处理器转向采用一种更加平衡的方法,包括高度专业化的异构计算元素、更快的数据移动和显著降低的功率。

这一转变的一部分围绕着采用 2.5D/3.5D 封装的芯片,这可以针对不同的工作负载和数据类型实现更大的定制化,并提高每瓦性能。除此之外,领先的芯片制造商还利用最近的Hot Chips 24会议展示了新颖的微架构、预取和分支预测方面的改进、更快的内存访问以及更智能的片上和片外数据管理。

由于当今电网的限制,政府机构和公用事业公司要求芯片制造商减少处理大型语言模型所需的能源,而芯片制造商正对此作出反应。他们还利用这些异构架构在超大规模和边缘数据中心挖掘新机遇。

这些新设计还瞄准了 NVIDIA 在 AI 领域的近乎垄断地位,因为廉价 GPU 和基于 CUDA 的模型大量涌现。没有哪种通用处理器能像定制加速器那样节能,而且今年 Hot Chips 上展示的大多数多芯片架构都不是单一类型的芯片,而是包含多种类型的处理器、更广泛的内存和 I/O 配置以限制瓶颈,以及更高效的数据管理。

当然,NVIDIA 非常清楚这些竞争威胁,而且该公司肯定不会停滞不前。其新款 Blackwell 芯片将 GPU 与 CPU 和 DPU 结合在一起,其量化方案除了具有处理更大规模数据模型所需的极快训练能力外,还为低精度 AI 打开了大门。

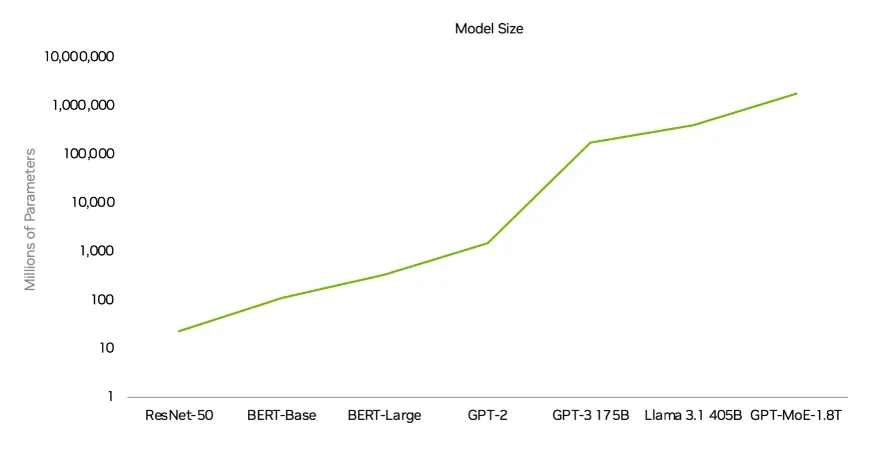

图 1:随着新功能和参数的增加,AI 模型在十年内增长了 70,000 倍。资料来源:NVIDIA/Hot Chips 24

NVIDIA GPU 架构总监 Raymond Wong 在 Hot Chips 24 演讲中表示:“与通用计算不同,人工智能和加速计算是一个全栈问题,需要从头开始重新审视软件和计算。问题的规模和我们所需的性能需要一种新方法,从上到下和从下到上寻找解决方案,涵盖硬件、系统软件、加速库、平台和应用程序框架……我们必须学会如何优化芯片、网络和基础设施。”

NVIDIA 未来仍有大量的扩张机会,但未来它将在许多方面面临更激烈的竞争。

数据中心的变化

今年处理器设计的一大变化是更加注重数据管理。有了人工智能,它不再只是构建大量冗余处理单元并尽可能快地运行它们。越来越多的目标是智能地对数据进行优先级排序——数据越来越多,数据类型也越来越多——但这种方法并不新鲜。事实上,它可以追溯到 1980 年,当时英特尔推出了 8087 浮点协处理器。Arm 在 2011 年通过其 big.LITTLE 双核处理器扩展了这一概念,较小的核心针对计算密集度较低的作业,较大的核心则用于需要时。

此后,这一策略通过更复杂的分区和优先级划分不断完善,但这种策略通常与大型数据中心中运行的 AI 芯片无关。大多数 AI 训练都在那里进行,而且训练可能会在那里继续驻留一段时间,因为开发大型语言模型并反复查询它们需要大量的计算能力。不过,并非每个计算周期都是处理密集型的,生成式 AI 模型确实需要像今天这样频繁地查询。

甚至连 IBM 也已将重点从每秒万亿次运算 (TOPS) 转向每瓦性能 (即每秒皮焦耳)。IBM 声称其大型计算机处理了全球 70% 的金融交易,但 IBM 也已将重点从每秒万亿次运算 (TOPS) 转向每瓦性能 (即每秒皮焦耳)。这一点尤其值得注意,因为与大型系统公司不同(目前约占所有前沿芯片设计的 45%),IBM 将其系统出售给终端客户,而不仅仅是将计算作为一种服务。

IBM 的新款 Telum 处理器包含用于 I/O 加速的数据处理单元 (DPU)(基本上就是将数据汇集到要处理和存储的位置)以及创新的缓存。总共包含 8 个以 5.5 GHz 运行的内核、10 个 36 兆字节的 L2 缓存和一个新的加速器芯片。

IBM 杰出工程师 Chris Berry 表示:“DPU 被业界广泛用于高效处理大量数据。大型机处理大量数据。一台完全配置的 IBM z16 每天能够处理 250 亿笔加密交易。这比 Google 搜索、Facebook 帖子和推文每天的加密交易量总和还要多。这种规模需要的 I/O 功能远远超出了典型计算系统所能提供的范围。它需要自定义 I/O 协议来最大限度地减少延迟,支持数千个操作系统实例的虚拟化,并可以随时处理数以万计的 I/O 请求。”

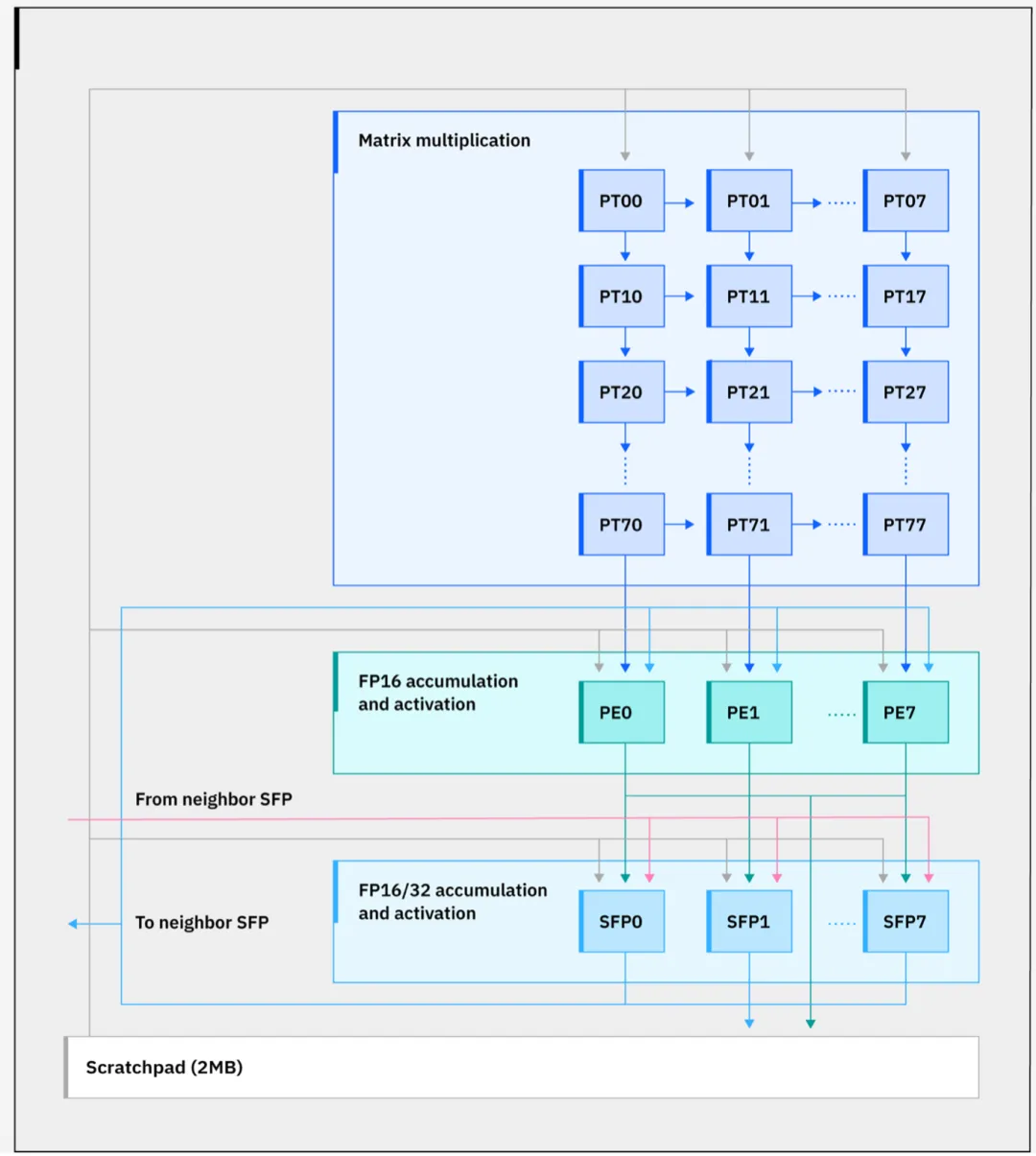

新芯片的八核中央计算综合体功耗降低了 15%,部分原因是分支预测功能更强大。过去几年,这一直是 Hot Chips 大会的主题,更准确的分支预测和更快的预取错误恢复可以提高性能。但 DPU 的加入更进一步,充当数据的智能交通警察。Berry 指出,DPU 直接安装在处理器芯片上,可以将 I/O 管理所需的功耗降低 70%。此外,加速器芯片的 32 个内核中的每一个都配备了 2MB 暂存器,他将其描述为“简单地存放数据以备后用”,每瓦性能的改进值得关注。

图 2:IBM 的新型 Spyre 加速器架构。来源:IBM/Hot Chips 24

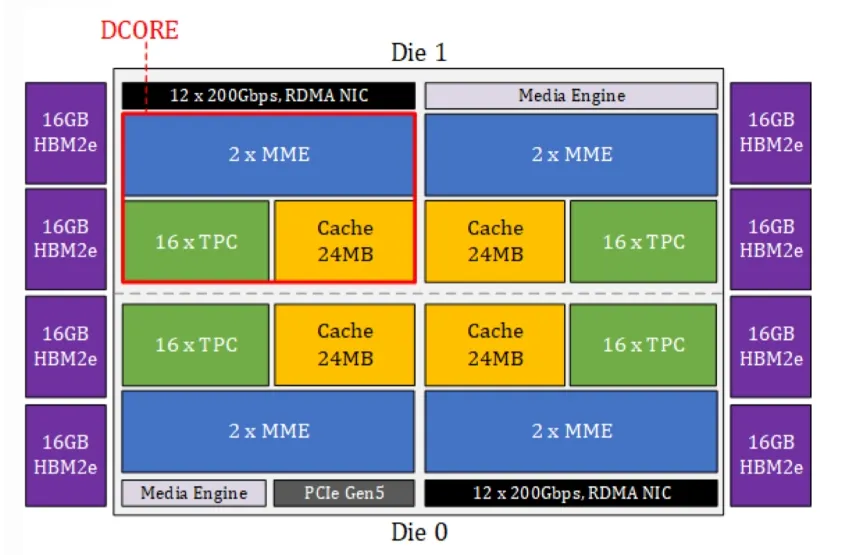

英特尔还推出了用于 AI 训练的下一代加速器芯片 Gaudi 3,该芯片具有 4 个深度学习核心 (DCORE)、8 个 HBM2e 堆栈、一个可配置而非可编程的矩阵乘法引擎。此外,它还具有 64 个张量处理核心和一个内存子系统,其中包括 L2 和 L3 缓存和 HBM 的统一内存空间、近内存计算以及一个集成软件套件,允许客户插入自定义 TPC 内核,并支持 PyTorch。它还通过中介层桥连接两个计算芯片。

英特尔在设备内管理数据的方法在概念上与 IBM 类似。英特尔使用同步管理器将工作分派给指定单元,并使用运行时驱动程序通过配置同步管理器来设置工作依赖关系。这种方法可以最大限度地提高系统内的资源利用率,并通过使用中断管理器异步传递事件来避免任何瓶颈。

英特尔首席 AI 性能架构师 Roman Kaplan 表示:“每个深度学习核心都包含 2 个 MME(矩阵乘法引擎)、16 个张量处理核心和 24 兆字节缓存。芯片的主要主力是 MME。它执行所有可以转换为矩阵乘法的运算。这是一个可配置的(而非可编程的)引擎,这意味着您不需要在该引擎上运行任何代码。有一组固定的寄存器控制该单元的操作,根据这些值,该单元就可以正常工作。每个 MME 单元基本上都是一个大型输出固定脉动阵列。”

图 3:英特尔 Gaudi 3 AI 框图。来源:英特尔/Hot Chips 24

AMD 的 MI300X 芯片面向 AI 系统,基于由 12 个芯片组成的分布式 AI 系统,具有 4 个 I/O 芯片和 8 个加速器芯片,同样可以将数据传输到最佳处理位置。AMD 高级研究员兼 Instinct 首席 SoC 架构师 Alan Smith 表示:“生成式 AI 模型性能需要内存容量和带宽。因此,我们将 MI300X 的规模作为目标,以满足这一需求,并实现单片设计无法实现的集成度。MI300X 采用第四代 Infinity 结构、PCI Express Gen 5、HBM3 和 CDMA3 架构,可在计算、内存和 I/O 子系统之间实现平衡扩展。”

图 4:AMD 基于 MI300X 芯片的 AI 芯片。来源:AMD/Hot Chips 24

边缘变化

过去,AI 处理领域主要分为超大规模数据中心的训练和小型设备(通常是移动设备)的推理。由于移动大量数据的成本以及获取查询结果所需的时间,训练和推理都越来越多地转向边缘。虽然 LLM 不断扩展,但它们并不是唯一被训练的 AI 模型。可以使用不太密集的计算基础设施来训练更小、更特定领域的模型,并且可以在带电池的设备上进行推理。

这为使用小芯片的异构设计开辟了一个全新的市场,并非所有小芯片都将由同一家公司或代工厂开发。HBM 是这个方向的第一个巨大成功,但小芯片正在被设计用于一系列不同的应用程序,类似于过去几十年软 IP 的使用方式。与数据中心 AI 芯片一样,管理数据移动和内存是关键。

英特尔的 Lunar Lake 是该芯片制造商针对移动和桌面计算的答案。英特尔 CPU SoC 硬件架构负责人 Arik Gihon 指出了该芯片的四个主要目标——能效、核心性能、改进的图形和整体性能,最高可达 120 TOPS。英特尔的方法是分离逻辑,使用 2.5D 配置的计算块和平台控制器块,并带有封装内存。

“Lunar Lake 由两个主要模块组成,”Gihon 说道。“一个是计算模块,另一个是平台控制器芯片。计算模块采用台积电 N3B 制造,PCB 采用台积电 N6 制造。基础芯片采用英特尔 1227 制造,它们通过 Foveros 技术连接。我们还引入了封装内存,它有两大优势。一是功率。由于互连少,它使我们能够专门针对低功耗优化 PHY,以及专门针对封装内存的优化。二是主板上的占用空间,最大可达 250 平方毫米。 ”

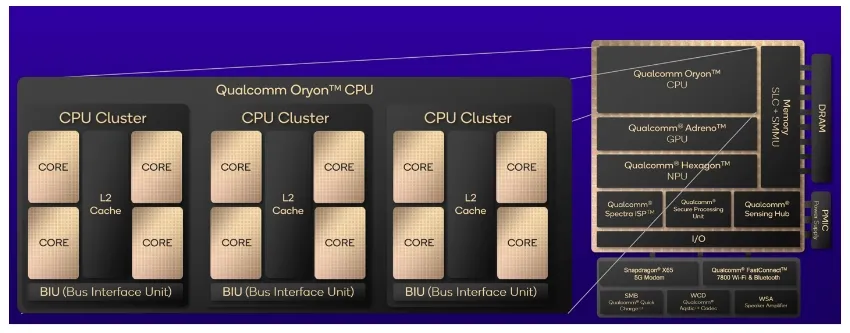

与此同时,高通也按照同样的思路开发了定制的 Oryon SoC。它包括三个 CPU 集群,每个集群有四个核心。其中两个专注于性能,一个专注于能效。在许多演示中,最引人注目的是微架构,它基本上就是指令在硬件上的执行方式。与更大的系统一样,数据在何处处理和存储是许多此类设计的核心。

高通公司工程高级副总裁 Gerard Williams 表示:“[Oryon] 有八个基本解码器,它们正在为执行单元、加载存储单元和矢量执行单元准备指令。指令本身进入重新排序缓冲区。它大约有 600 个条目,这让您大致了解机器在飞行过程中要管理多少条指令。从退出的角度来看,这台机器每个周期可以退出八条指令。”

高通芯片中特别值得注意的是内存管理单元。“它由一个非常大的统一二级转换缓冲区支持,这主要是为了处理大量数据,”威廉姆斯说。“它旨在处理所有虚拟化结构、安全层,但这个结构远大于 8 千个条目,这是非常不常见的。它旨在将转换延迟降至最低。”

图 5:高通 Oryon SoC 示意图,效率和速度并重。资料来源:高通/Hot Chips 24

会议上的许多演讲者都是熟悉的名字,但也有一些新人。例如,FuriosaAI 是一家总部位于韩国的初创公司,正在开发用于边缘的 AI 芯片。该公司开发了一种所谓的张量收缩处理器,用于可持续的 AI 计算。

“虽然训练是关于人工智能模型的,但推理是关于服务和部署的,”联合创始人兼首席执行官 June Paik 表示。“我们在 2021 年的原始设计针对 BERT 规模的模型进行了优化。然而,随着 GPT3 等基础模型的出现,我们很快在设计上做出了重大转变——该模型比 BERT 大五倍。尽管这些庞大的模型主要处于研究阶段,但我们对它们的潜力充满信心。我们相信人们会倾向于最强大的人工智能模型,因为更智能的模型会带来更大的好处。我们还相信,随着这些应用的扩展,效率将变得更加重要。因此,我们着手将 RNGD打造为最高效的推理芯片。”

其架构的核心是快速地将数据来回移动到内存,该架构面向边缘数据中心。该公司声称内存带宽为 1.5 TB/秒。RNGD 还拥有两个 HBM3 堆栈和 256 MB SRAM,以及 48 GB 内存容量。

图 6:Furiosa 的可持续边缘推理芯片架构。来源:Furiosa/Hot Chips 24

结论

AI 刚刚开始发挥作用,但未来仍面临挑战。首先,AI 必须是可持续的,大型芯片公司非常理解这一点,Hot Chips 24 上展示的芯片架构就是明证。但芯片只是解决方案的一部分。

可持续性还需要更高效的软件、微架构的改进,以便减少大型语言模型查询的发生频率,以及越来越精确的响应,以便 LLM 响应值得信赖。此外,它还需要以芯片的形式更紧密地集成专用处理元件,这些芯片能够更快、更高效地处理不同类型的数据。

底线是:人工智能不会消失,但要充分发挥其潜力,需要整个半导体生态系统的努力。

参考链接

https://semiengineering.com/new-ai-processors-architectures-balance-speed-with-efficiency/

本文转载自:半导体行业观察