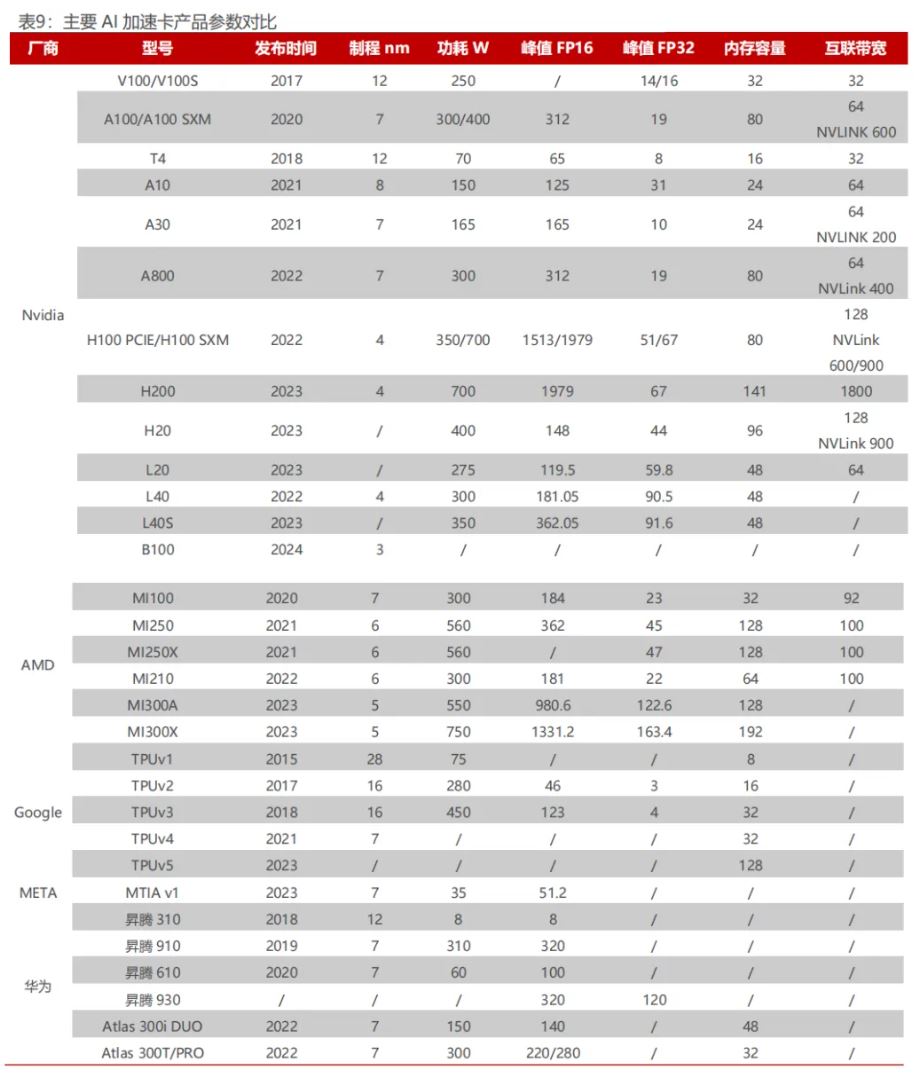

AI芯片市场规模持续扩大 ,GPGPU芯片成长空间更为广阔。根据Frost&Sullivan 的数据, 2021 年全球人工智能芯片市场规模为 255 亿美元。预计从 2021 年到 2026 年,全球人工智能芯片市场规模将以 29.3%的复合增长率持续增长。到 2023 年,该市场规模将达到 490 亿美元;而到 2026 年,市场规模将增长至 920 亿美元。

AMD 于 2023 年 Q2 官宣的 MI300 系列产品引得广泛关注,相较于历代产品在各方面都有了质的提升,有望与行业巨头英伟达旗下高端芯片 Grace Hopper媲美。

本文来自“AMD:算力帝国的挑战者(2024)”,前篇内容参考文章“AMD:算力帝国的挑战者(2024)”。

在芯片设计方面,MI300 基于 AID(有源中介层芯片)构建块,采用台积电的N6工艺制造。该芯片配备2个HBM内存控制器、64MB末级附加内存(MALL)无限缓存、36 通道 xGMI/PCIe/CXL 以及 AMD 片上网络(NOC)。在 4 个区块配置中,MALL 缓存为 256MB,而 H100 为 50MB。AID 最重要的部分是它在CPU 和 GPU 计算方面是模块化的。AMD 和台积电使用混合键合将 AID 连接到其他小芯片。这种通过铜 TSV 的连接允许 AMD 混合并匹配 CPU 与 GPU 的最佳比例。

MI300 系列性能强劲,硬件参数领先

MI300 的四个 AID 以超过 4.3TB/s 的对分带宽相互通信,通过超短距离(USR)物理层实现。每个 AID 共可以有 2 个 Banff 芯片,总共 76 个 CU。MI300 的最大 XCD/GPU 配置将提供 304 个 CU。与具有 220CU 的 AMDMI250X 相比提升了近 140%。每个 AID 可以有 3 个 Zen4 小芯片,总共 24 个核心。MI300 的最大 CCD/CPU 配置可提供多达 96 个核心。在 GPU 方面,计算小芯片称为 XCD,代号为 Banff。Banff 采用台积电 N5 工艺技术,尽管仅启用了 38 个 CU,但它总共包含 40 个计算单元。

从架构角度来看,MI300 是一款采用先进的 CPU+GPU 仿生人脑结构的产品。它是 AMD 首个将 Zen4 CPU 和 CNDA3 GPU 结合的一体化产品,也是市场上首个集成了"CPU+GPU+内存"的产品。MI300 采用了 3D 堆叠技术和 Chiplet设计,配备了 9 个基于 5nm 制程和 4 个基于 6nm 制程的芯片组。在制程方面,MI300 与英伟达 Grace Hopper 的 4nm 制程(实属于台积电 5nm 体系)相当。

它拥有 1460 亿个晶体管数量,超过了英伟达 H100 的 800 亿个和前代产品MI250X 的 582 亿个。其核心架构为 AMD 的新一代 CDNA3 架构,具备 24 个Zen 4 数据中心 CPU 核心和 128GB HBM3 内存,并以 8192 位宽总线运行。相较于 AMD CDNA2 架构,预计 CDNA3 架构在 AI 训练工作负载上的每瓦性能将提高超过 5 倍以上,这使得 MI300 能够为 AI 训练等任务提供更高效的性能。

MI300 性能逼近 H100。MI300 采用了 8 个 HBM3 堆栈包围 4 个象限的硅晶片。新的 HBM3 的最高速度为 5.6 GT/s,八个 16GB 或 24GB 堆栈形成 128GB或 192GB 统一内存,带宽高达 5.6 TB/s。与 Nvidia H100 SXM 80GB 相比,带宽提高了 72%,容量提高了 60%至 140%。算力方面,MI300X 的峰值 FP16 性能可以达到 1331TFLOPS。

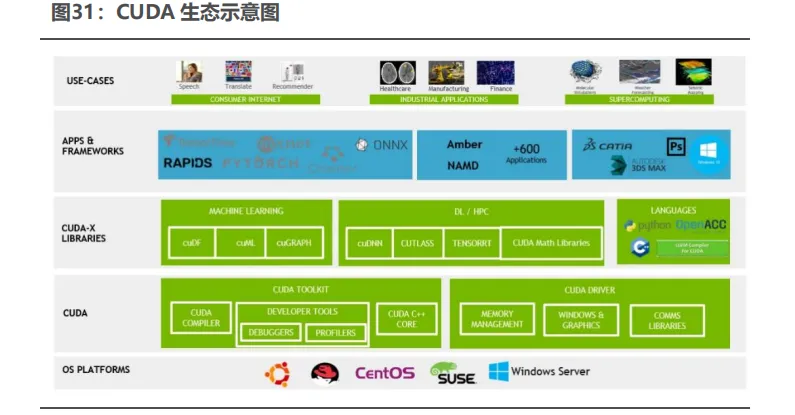

GPU 的软件生态主要包括一些开源或专有的平台和工具,它们允许开发者利用 GPU 进行高效的并行计算。在 GPU 市场中,成熟的软件生态已成为各厂商之间难以逾越的护城河。相较于不断迭代的微架构技术,生态所带来的用户粘性在长期竞争中显得更为关键。

目前英伟达的 CUDA、AMD 的 ROCm、微软的 DirectX 以及 OpenCL、OpenGL、Vulkan 等已成为主流的开发平台,为开发者提供高效、便捷的 GPU 计算解决方案,随着技术的不断发展和应用场景的不断拓宽,这些平台将继续发挥重要作用。

CUDA 是英伟达于 2006 年推出的一种异构计算平台,开发人员能够通过CUDA 对 GPU 进行通用计算(GPGPU)的部署。在 CUDA 编程模型中,Host代表主机部分,主要由 CPU 和主机内存组成;而 Device 代表设备部分,主要由GPU 和显存构成。Host 与 Device 之间通过 PCI Express 总线进行高效的数据传输和通信。这种架构使得 CUDA 能够充分利用 GPU 的并行计算能力,实现高性能的并行计算任务。

CUDA 在 Host 运行的函数库包括了 Libraries、Runtime 和 Driver 三大部分。其中,Libraries 通常是一些成熟的高效函数库,Runtime API 则简化了应用开发过程,提供了便捷的接口和组件,让开发者能够轻松地调用并自动管理 GPU资源。应用程序可以通过调用 CUDA Libraries 或者 CUDA Runtime API 来实现所需功能。效的控制 GPU 资源的能力。当涉及到 Device 端的计算任务时,CUDA使用内核函数进行并行计算和数据处理,从而充分发挥 GPU 的性能优势。

CUDA 生态支持多种编程语言。目前的 CUDA 12.0 支持 C、C++、Fortran、Python 等多种编程语言,还支持众多第三方工具链。此外,英伟达在 CUDA 平台上提供了 CUDA-X,CUDA-X 是一个功能强大且灵活的软件加速库集合,开发人员可以通过 CUDA-X 快速将这些库部署到多种设备内的 NVIDIA GPU 上,包括台式机、工作站、服务器、云计算和物联网(IoT)设备。CUDA 平台对开发者友好程度高,其提供的一系列容器部署流程简化以及集群环境扩展应用程序的工具使得 CUDA 技术能够适用于更广泛的领域。

ROCm:扩大优势,持续追赶 CUDA 生态

AMD 于 2016 年 4 月发布了 ROCm 生态系统,目标是建立可替代英伟达CUDA 的生态系统。最新版本的 ROCm 生态系统支持 HIP 和 OpenCL 编程模型,可顺利迁移 CUDA 应用,并增强了对 AI 框架如 TensorFlow、PyTorch 和 MXNet等的支持。同时,新版本还优化了 ROCm 库和工具的性能与稳定性,为用户提供更高效稳定的计算体验。

与其竞争对手相比,AMD 的软件生态系统在一些方面具有不同的特点和优势:

1.开放性与开源:AMD 采用开放的软件战略,致力于提供开放源代码的解决方案。AMD 的 ROCm 平台是一个开源项目,允许开发者自由地使用、修改和贡献代码。这种开放性促进了社区的合作和创新,并且使得用户能够更加灵活地定制和优化软件。

2.广泛的操作系统支持:AMD 的软件生态系统广泛支持多个操作系统,包括Windows、Linux 和 macOS。这使得用户能够在各种环境下进行开发和部署,以满足不同的需求。

3.多供应商支持:AMD 的软件生态系统不仅支持 AMD 自家的处理器和显卡产品,还支持与其他供应商的硬件集成。例如,AMD 的 ROCm 平台支持多种 AMDGPU 架构,如第四代 GNC 架构 Polaris、RDNA2/3、CDNA2/3 等,这为用户提供了更多的选择和灵活性。

与 CUDA 相比,ROCm 也存在一些劣势。尽管 ROCm 在不断发展和改进,但相对于已经成熟的 CUDA 系统,其生态系统和工具链的成熟度还有一定差距。

首先,它仅支持 Instinct、Radeon 系列产品,而 CUDA 则涵盖了英伟达大部分产品线。其次,与英伟达相比,AMD 在 GPU 市场份额上的竞争力相对较低,因此 ROCm 的生态系统相对较小,这可能导致较少的第三方库、工具和文档资源可用。英伟达的CUDA软件库广泛覆盖了多个领域,而ROCm软件库只包括了CUDA中的一些部分功能,如部分数学函数、深度学习库等,主要被研究机构使用,价值量较低,并且在应用场景的拓展上存在较大困难。

综合来看,AMD 的软件生态系统在开放性、多供应商支持和合作伙伴关系等方面具有优势。如果开发者注重开放性和平台灵活性,以及希望避免对特定硬件供应商的依赖,那么 ROCm 可能是一个更好的选择。为了进一步追赶 CUDA 生态,AMD 应当进一步拓展硬件支持,加强 ROCm 生态系统构建,并优化硬件与软件的协同,聚焦关键应用领域,从而提高在关键领域的竞争力。

文章来源:智能计算芯世界