关于卷积神经网络,这些概念你厘清了么~

judy 在 周三, 10/23/2024 - 14:23 提交

本文基于此解释了卷积神经网络(CNN)及其对人工智能和机器学习的意义。

本文基于此解释了卷积神经网络(CNN)及其对人工智能和机器学习的意义。

本文主要介绍了在边缘设备上部署卷积神经网络(CNN)的一种方法,使用现场可编程门阵列(FPGA)和Gemmini加速器

最近加州大学发布了一篇文章,文章介绍了一种名为MatMul-free语言模型的新技术。

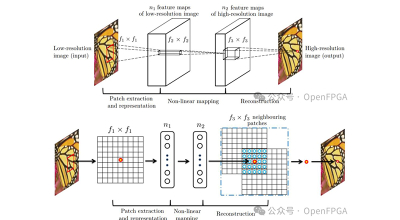

本文介绍对超分辨率卷积神经网络 (SRCNN) 的三种实现方式

在这个项目中,将在线和离线 TSM 网络部署到 FPGA,通过 2D CNN 执行视频理解任务

本文介绍DPUCVDX8H,这是一个专门为Xilinx® Versal®平台设计的高性能CNN推理加速器。描述了DPU的特性、IP事实、使用该内核进行设计以及开发流程。

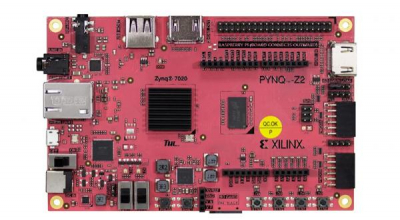

本示例工程中我们会在 TensorFlow2 下使用 Keras API 创建一个自定义 CNN 网络,在 Vitis-AI 1.3 环境下编译成 Xilinx DPU 上运行的模型文件,并在 Xilinx zynqMP 上部署运行。该示例工程应在 Vitis-AI1.3 Docker,vitis-ai-tensorflow2conda 环境中运行。

近来卷积神经网络(CNN)的研究十分热门。CNN发展的一个瓶颈就是它需要非常庞大的运算量,在实时性上有一定问题。而FPGA具有灵活、可配置和适合高并行度计算的优点,十分适合部署CNN。

在CNN网络中卷积运算占据了最大的计算量,压缩卷积参数可以获得显著的硬件加速器的性能提升。在即将介绍的这篇论文中,作者就是通过张量的降维来降低卷积计算量的。作者通过CP分解将一个4D张量分解成多个低维度的张量,并且最后通过微调参数来提升网络精度。

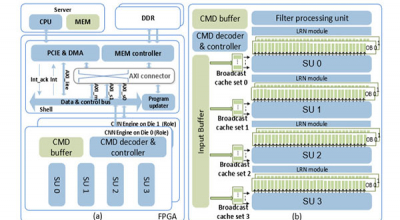

在本文中,我们开发了一个 FPGA 加速平台,该平台利用统一的framework架构,在数据中心实现通用卷积神经网络(CNN)推断加速。为了克服计算限制,4,096个DSP阵列用于不同类型卷积的超级单元(supertile units, SU),其在500MHz下提供高达4.2 TOP/s 16位定点性能。